Scrapy.http.Request

自动去重,根据url的哈希值,进行去重

属性

meta(dict) 在不同的请求之间传递数据,dict

priority(int) 此请求的优先级(默认为0)

dont_filter(boolean) 关闭自动去重

errback(callable) 在处理请求时引发任何异常时将调用的函数

flags(list) 发送给请求的标志,可用于日志记录或类似目的

方法

copy() 返回一个新的请求,改请求是此请求的副本

replace() 返回一个更新对的request

FormRequest

scrapy框架内置了一个FormRequest类,它扩展了基类Request,具有处理HTML表单的功能

post请求的时候,使用FormRequest将数据传入formdata参数即可

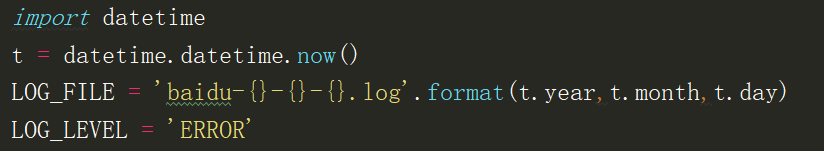

日志使用

LOG_FILE 日志输出文件,如果为None,就打印在控制台

LOG_ENABLED 是否启用日志,默认True

LOG_ENCODING 日期编码,默认utf-8

LOG_LEVEL 日志等级,默认debug

LOG_FORMAT 日志格式

LOG_DATEFORMAT 日志日期格式

LOG_STDOUT 日志标准输出,默认False,如果True所有标准输出都将写入日志中

LOG_SHORT_NAMES 短日志名,默认为False,如果True将不输出组件名

一般只在settings配置文件中添加